世界超大的多语言语音数据集现已开源!超40万小时,共23种语言

本文经AI新媒体量子位(公众号ID:QbitAI)授权转载,转载请联系出处。

最近,Facebook开源了目前世界上最大的多语言语音数据集,VoxPopuli:

这一数据集共涵盖了23种语言,时长超过40万小时。

其中,每种语言都有9000到18000小时的无标签语音数据。

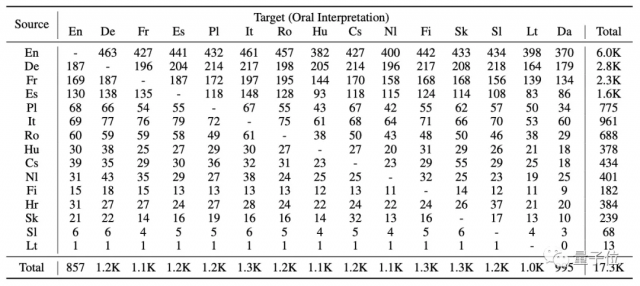

此外,还包括了共1800小时,16种语言的转录语音数据,以及17300小时,15种目标语言的口译语音数据。

国外网友很快为这一行为点赞:

显然,如果数据集已经存在,那么它应该被利用,并以一种道德的方式来改善人类社会。

这一数据集庞大的无标签数据量和广泛的语言覆盖率,对改进自监督模型有着很大的帮助。

而Facebook也希望能够帮助提高语音数据集的质量和鲁棒性,使训练语音转换神经网络更加可靠。

最终加速新的NLP系统的开发,使AI翻译的效果越来越好。

而数据集的名字,VoxPopuli的直译“人民的心声”也表示了其原始数据的来源——

即源语音全都收集自2009-2020年欧洲议会的活动录音。

来自10年欧会的语料库

在欧洲议会的各自活动,如全体会议、委员会会议和其他活动上,发言者都会以不同的欧盟语言轮流发表演讲。

Facebook就是从欧会官网上抓取了每个演讲的文字记录、演讲者信息、开始/结束时间戳。

然后,将所有的原始演讲数据进行处理,大致分为以下3类:

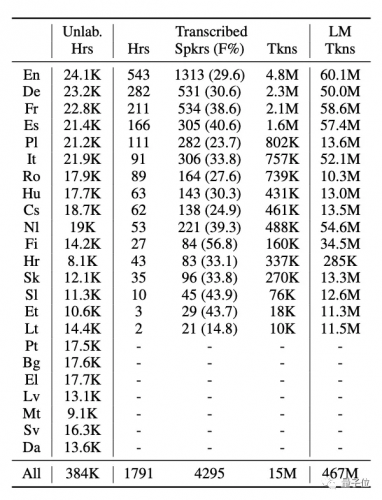

共40万小时,23种语言的无标签语音数据

每种语言都有8千到2万多的原始语音数据。

因此,Facebook基于能量的语音激活检测(VAD)算法,将完整音频分割成15-30秒的短片段。

最终得到没有太多的数据不平衡,也不需要调整数据采样策略的数据集。

因此非常适合多语言模型的训练。

而上表中除了无标签数据,也有转录的语音数据,这也就是第二种:

共1800小时,16种语言的转录语音数据

欧会官方的时间戳虽然可以用来在会议中定义演讲者,但常常会被截断,或混合前后演讲的片段,因此并不完全准确。

所以Facebook对全会话音频采用了声纹分割聚类(SD)。

这时的语音段落平均时长为197秒,再利用语音识别(ASR)系统,将其细分为20秒左右的短片段。

观察上表,可以看到最终得到的数据中,有包括各语言的持续时间、发言人数量、女性发言人百分比、标记数量等多种属性。

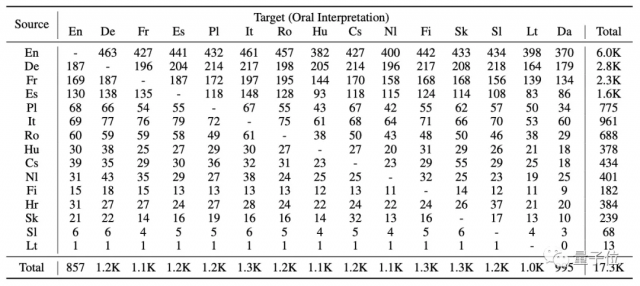

17300小时的15种目标语言的口译语音数据:

每个原始语音都有相对应的同声传译,并互相关联。

但要使这个数据集可用,必须经过大量的预处理和过滤。

因此,Facebook使用了语音识别(ASR)系统在句子层面上对齐源语音和目标语音。

在域外环境的半监督学习下具有通用性

那么这一数据集用起来到底怎么样?

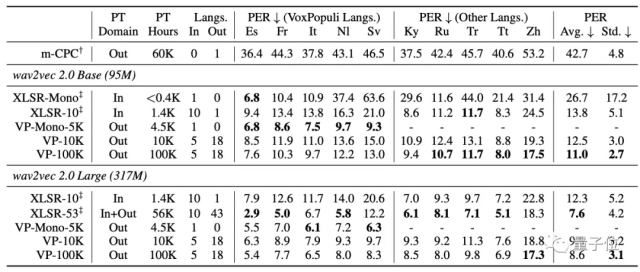

首先,是使用包含了域外语言(out-of-domain out-of-language)的无监督预训练,进行少样本的语音识别:

可以从表中看到,VP-Mono5K在5种VoxPopuli语言上,都优于XLSR-Mono和XLSR-10。

而VP-100K则在10种语言中的8种上的都比XLSR-10的表现更好。

并且,虽然XLSR-53涵盖了Zh语言,但与VP-100K(Large)在Zh上的表现相距甚远。

这表明VP-100K所学的语音表征具有高度的通用性。

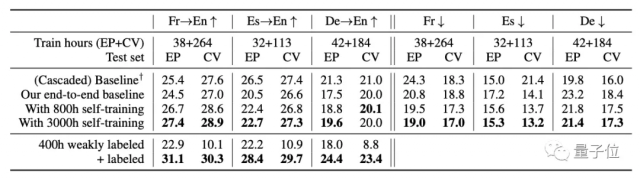

然后是使用VoxPopuli数据集进行自我训练或弱监督的语言翻译(ST)和语音识别(ASR):

从表中可以看到,不管是对于域内语言还是域外语言,对VoxPopuli的自我训练在大多数时候都能够提高性能。

而在翻译上,也不用再增加昂贵的标签数据。

通过自我训练,就能够缩小端到端模型和级联模型之间的差距。

论文地址:https://arxiv.org/abs/2101.00390

下载:https://github.com/facebookresearch/voxpopuli

相关阅读

-

云安全日报210527:Ubuntu配套LZ4解压缩软件发现执行任意代码漏洞,需要尽快升级

Ubuntu是一个以桌面应用为主的Linux操作系统。它是一个开放源代码的自由软件,提供了一个健壮、功能丰富的计算环境,既适合家庭使用又适用于商业环境。Ubuntu将为全球数百个公司提供商业支持。 ...

查看全文 -

云计算核心技术Docker教程:清理未使用的Docker对象

Docker采取了一种保守的方法来清理未使用的对象(通常称为“垃圾收集”),例如图像,容器,卷和网络:除非您明确要求Docker这样做,否则通常不会删除这些对象。这可能会导致Docker使用额外的磁盘空...

查看全文 -

消息称亚马逊、微软、谷歌正竞购波音公司10亿美元云合同

新浪科技讯 北京时间5月27日晚间消息,据报道,四位知情人士今日透露,亚马逊、微软和谷歌这三大云计算服务提供商,正在竞争波音公司(Boeing)价值10亿美元的云服务合同。 这些...

查看全文 -

亚马逊难逃反垄断惩罚?美国又有三个州加入调查

新浪科技讯 北京时间5月27日晚间消息,据报道,多位知情人士今日称,继加州、纽约州和华盛顿州之后,马萨诸塞州和宾夕法尼亚州的总检察长也加入到对亚马逊的反垄断调查中。 如今,越来越...

查看全文

您好!请登录